آیا “Small Data” مسئلهی مهم بعدی در علم داده است؟

- دسته:اخبار علمی

- هما کاشفی

Andrew NG یکی از پیشگامان هوش مصنوعی پیش کرده است که دههی آینده شاهد هوش مصنوعی داده محور خواهد بود. اگر تنها 50 نمونه دادهی خوش ساخت داشته باشیم، ممکن است دیگر به میلیونها نمونه دادهی نویزی نیاز نداشته باشیم.

در حدود دو دههی گذشته، ما در عصر Big Data زندگی کردهایم. با کم هزینهتر شدن ظرفیت ذخیره سازی و توان محاسباتی، میتوانیم حجم عظیمی از دادهها را ذخیره و پردازش کنیم و به بینش جدیدی دست پیدا کنیم. با وجود موفقیتهای گوگل، آمازون و فیسبوک، پیشرفتهای قابل توجهی در تحلیل دادهها در مقیاس بزرگ حاصل شده است و تصمیم گیری مبتنی بر داده به اولویت اصلی بسیاری از شرکتها تبدیل شده است.

ما شاهد شبکههای عصبی غول پیکر با میلیونها پارامتر برای تنظیم بودهایم. جریانهای عظیمی از دادههای رسانههای اجتماعی که در زمان واقعی پردازش میشوند. پتابایت اطلاعات ریز استخراج شده از سنسورهای فرکانس بالا و اطلاعات مربوط به کاربر که در سرورهای عظیم ذخیره شدهاند. پیشرفتها، فراوان و نشاط آور بودهاند.

بی شک چنین روندهای Big Data ادامه خواهند داشت. تا زمانی که دادههای بیشتری برای جمع آوری وجود داشته باشند، راههای جدیدی برای استفاده از آنها پیدا خواهیم کرد. به عنوان مثال، پردازش زبان طبیعی به بلوغ رسیده است، با این حال تحلیل ویدیویی هنوز در انتظار پیشرفتهای تکنولوژیکی برای پیشبرد است.

با این وجود، دنیایی خارج از Silicon Valley وجود دارد که نادیده گرفته میشود. میلیونها شرکت کوچک و متوسط (و سایر سازمانها) با مشکلاتی دست و پنجه نرم میکنند که راه حل آنها، داده است. این سازمانها فقط میخواهند بینش ارزشمندی از مجموعه دادههای کوچک خود استخراج کنند و برای این منظور از آخرین هنر در یادگیری ماشین بهره میبرند؛ دیگر بر مجموعه دادههای عجیب و غریب و بزرگ تکیه نمیکنند.

برای اینکه کاربردهای بالقوه برایتان ملموستر شود، تنها کافی است چند مثال زیر را در نظر بگیرید:

حسابداری هزینه: پیش بینی هزینهها برای ماشینهای سفارشی

مراقبتهای سلامتی: شناسایی تومورها در تصاویر اشعه ایکس

تولید: تشخیص خودکار عیوب در خط تولید

ارتباط چنین مثالهایی برجسته است، نقش محوری همهی آنها توسط داده ایفا میشود. با این حال، اینها لزوماً تسکهایی نیستند که میلیاردها داده برای آنها به آسانی در دسترس باشد، به ویژه در مورد نقص یا بیماریهای نادر. برای بهره برداری حداکثری از یادگیری ماشین مدرن، به زاویه دید متفاوتی نیاز داریم.

یک تغییر پارادایم؟

Andrew NG را به یاد بیاورید، پس از تأسیس Google Brain، تدریس در استنفورد، راه اندازی پلتفرم یادگیری آنلاین Coursera (شامل دورهی بسیار محبوب «یادگیری ماشین») و پیشگام در استفاده از CPU برای یادگیری ماشین، با اطمینان خاطر میتوان گفت او فرد معتبری است و گوش دادن به او سودمند است.

اندرو استدلال میکند که در سالهای گذشته، تمرکز جامعه بر هوش مصنوعی مدل محور، با تأکید بر طراحی، تنظیم دقیق و بهبود الگوریتمهای مناسب برای تسکهای مختلف (متن کاوی، تشخیص تصویر و …) بوده است.

پژوهشهای مدل محور بسیار مثمر ثمر بوده است و در بسیاری از معماریهای با کیفیت بالا به اوج خود رسیده است. با این حال، برای حفظ جنبش، طراحی و بهبود الگوریتمها به تنهایی کافی نیست. برای پیشرفت واقعی، باید کیفیت ورودی مدل با کیفیت مدل مطابقت داشته باشد.

در ادامه هوش مصنوعی مبتنی بر داده را با عمق بیشتری بررسی خواهیم کرد، اما ابتدا باید بر هوش مصنوعی مبتنی بر مدل بپردازیم.

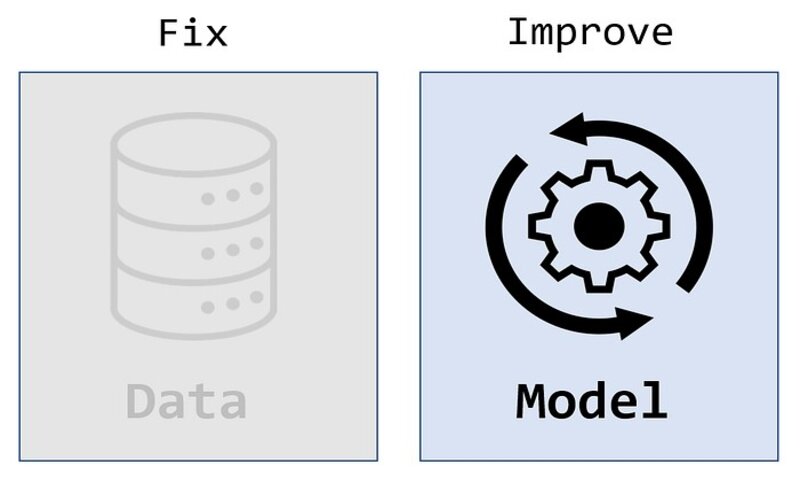

هوش مصنوعی مبتنی بر مدل (Model-Centric AI)

در هوش مصنوعی مبتنی بر مدل، فرض شده است که داده را در اختیار داریم. تمرکز اصلی بر بهبود مدل است و سعی برای دستیابی به بهترین عملکرد ممکن با مجموعه ثابتی از دادهها

به لحاظ سنتی، داده به عنوان ورودی الگوریتمها در نظر گرفته میشد. پرسش اصلی آن است که کدام الگوریتم یادگیری ماشینی، بیشترین نیاز به داده را دارد. آیا به درختان تصمیم یا شبکههای عصبی تقویت شده با گرادیان نیاز داریم؟ چند لایه، کدام توابع فعالسازی و کدام الگوریتم گرادیان نزولی؟ انبوهی از گزینهها که چالشهای زیادی را در شناسایی معماریهای مناسب ایجاد میکند. مجموعه دادههای بزرگ امکانی فراهم میآورند که بر دادههای نویزی و از دست رفته غلبه کنیم.

اندرو حدس میزند که هوش مصنوعی مدل محور اکنون به نقطه اشباع رسیده است. بسیاری از سوالات باز حل شدهاند و معماریهای مختلفی برای تسکهای مختلف و دشوار پیشنهاد شدهاند. به عنوان مثال، الگوریتم پردازش زبان طبیعی گوگل BERT بر روی زبان انگلیسی آموزش دیده است. برای یک زبان دیگر، ممکن است از معماری BERT به عنوان نقطه شروع استفاده کنیم-بهینه سازی و طراحی در طول مسیر به جای شروع از صفر.

هوش مصنوعی مدل محور، دستاوردهای زیادی برای ما به ارمغان آورده است. برای بسیاری از مسائل رایج، اکنون الگوریتمهای مناسبی داریم که ثابت شدهاند که خوب کار میکنند. منظور آن است که میتوانیم از مدلهای موجود برای کلاس خاصی از مسائل استفاده کنیم، نه اینکه برای هر نمونه مشکلی که با آن مواجه میشویم دوباره چرخ اختراع کنیم. در ترکیب با ابزارهای موجود دیگر نیازی نیست که متخصص الگوریتم باشیم.

بدیهی است که هوش مصنوعی مدل محور یک خیابان بن بست نیست-پیشرفتهای الگوریتمی همیشه ادامه خواهند داشت. با این حال کتابخانههای متن باز و معماریهای نمونه، راه طولانی را برای حل مسائل هوش مصنوعی در پیش دارند.

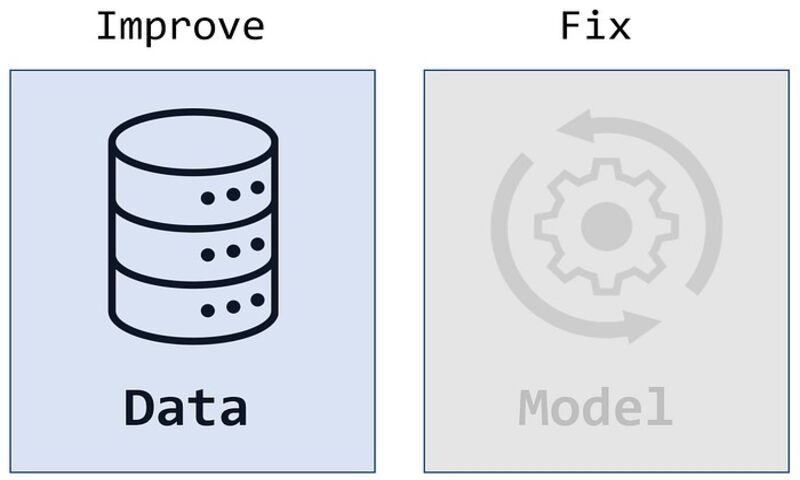

هوش مصنوعی داده محور (Data-Centric AI)

در هوش مصنوعی داده محور، مدلها کم و بیش ثابت فرض شدهاند. در عوض تمرکز اصلی بر بهبود کیفیت داده است با این هدف که درک عمیقتری از مجموعه دادههای کوچک بدست آید.

علیرغم حجم خیره کنندهی داده که هر روز تولید میشود، کیفیت چنین دادههایی ممکن است نسبتاً ضعیف باشد. دادههای از دست رفته، خطاهای ورودی یا اندازه گیری، دادههای تکراری، پیش بینیهای نامربوط همگی باعث میشوند آموزش مدل به کاری دشوار تبدیل شود. ممکن است مجموعه دادههای به اندازه کافی بزرگ بتوانند بر چنین موانعی غلبه کنند، با این حال مجموعه دادهای که هم کوچک و هم بی کیفیت است، دستورالعملی برای فاجعه است.

علاوه بر این ما اغلب فقط به زیر مجموعههای خاصی از دادهها علاقه مند هستیم. ده میلیون تصویر از ریههای سالم یا انبوهی از تراکنشهای غیرمتقلبانه کمک چندانی به مسئله نمیکنند. حتی زمانی که مجموعه دادهها در نگاه اول به اندازه کافی بزرگ هستند، ما اغلب با عدم تعادل شدید کلاسها روبرو هستیم و تنها چند مثال معنادار برای یادگیری در اختیار داریم.

پاکسازی دادهها معمولاً به صورت تکی و با تکیه بر هوشمندی دانشمندان داده انجام میشود. بدتر از آن مشخص نیست که کدام ویژگیهای داده بیشترین تأثیر را بر عملکرد مدل میگذارند که منجر به یک چرخهی خسته کنندهی آزمون و خطا میشود.

در مقابل، هوش مصنوعی مبتنی بر داده، رویکردی سیستماتیک و روشمند برای بهبود کیفیت داده ایجاد میکند. با شناسایی ویژگیهای برجسته، حذف نویز و تحلیل خطا و برچسب زدن، ممکن است اثربخشی آموزش به شدت بهبود یابد.

تا به حال، تمرکز اصلی به جای بهبود خود دادهها، بهبود خود مدلها بوده است. هدف هوش مصنوعی داده محور، تغییر این موضوع است.

تغییر مسیر به سمت مجموعه دادههای کوچک

مفهوم بهبود سیستماتیک کیفیت دادهها، منطقی است اما به طور مشخص، انتظار چه پیشرفتهایی را میتوانیم داشته باشیم؟ تغییر به سمت «دادههای کوچک و هوشمند» با تمرکز بر دادههای با کیفیت بالا و مثالهای قابل توضیح، کلیدی است.

معماریهای اثبات شده را میتوان با اصلاحات مجدد مورد استفاده قرار داد. هوش مصنوعی داده محور نیازمند تغییر اساسی در فرهنگ است. به جای آنکه با لایهها و هایپرپارامترها سر و صدا کنیم، زمان بیشتری را صرف برچسب گذاری و برش مجموعه دادهها خواهیم کرد. از آنجاییکه اینها تسکهایی هستند که لزوماً برای ما لذت بخش نیستند، این تغییر فرهنگ چیزی نیست که بتوان آن را ساده تلقی کرد.

دیدگاه ها