کتابخانه پایتورچ (PyTorch)

پایتورچ یک فریم ورک یادگیری ماشین مبتنی بر کتابخانه Torch است. یک کتابخانه قدرتمند پایتون برای کاربردهایی مثل بینایی ماشین و پردازش زبان طبیعی است که اولین بار توسط تیم هوش مصنوعی متا (فیسبوک) توسعه پیدا کرد و در سال 2016 منتشر شد. PyTorch ماهیت پایتونیک دارد که باعث میشه یادگیری اون در مقایسه به سایر فریمورکها بسیار سادهتر باشد. پایتورچ برای افزایش سرعت و انعطاف در پیادهسازی شبکههای عصبی عمیق طراحی شده است و برای همین یکی از فریم ورکهای ترجیحی برای تحقیقات یادگیری عمیق است. در این پست میخواهیم با PyTorch و قابلیتهای آن آشنا شویم.

کتابخانه پایتورچ

پایتورچ یک فریم ورک یادگیری ماشین متن باز است که مسیر تحقیقات تا رسیدن به محصول را تسریع میکند. PyTorch به دلیل انعطاف پذیری، سهولت استفاده و قابلیت های محاسباتی کارآمد شناخته شده است. در حال حاضر، PyTorch محبوب ترین کتابخانه برای محققان و متخصصان هوش مصنوعی در سراسر جهان در صنعت و دانشگاه است.

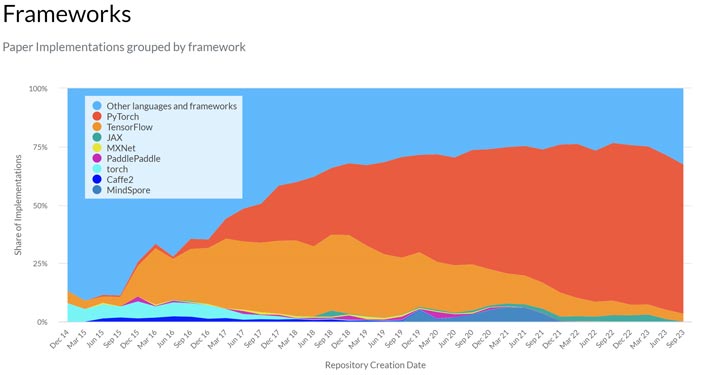

در سایت paperswithcode میتونید میزان استفاده کننده های پایتورچ در بین محققین رو ببینید. این وبسایت کد منتشر شده مقالات رو در گیتهاب چک میکند و بر اون اساس داده خود رو جمع آوری میکند. در شکل زیر میزان کدهای نوشته شده در فریم ورکهای مختلف از سال 2010 تا 2023 رو نشون میدهد. تا سال 2016 تنسورفلو بیشتر استفاده کننده را داشته است، اما از سال 2016 که پایتورچ منتشر شد، هر روز به استفاده کننده های این فریم ورک محبوب اضافه می شود. و از 2017 به بعد این فاصله با بقیه رقبا بسیار بیشتر شده است.

چند ویژگی خیلی خوب پایتورچ

- محاسبات تنسور با سرعت بالاتر با استفاده از GPU

- تنسورهای پایتورچ شبیه آرایه های نامپای هستند اما با یک ویژگی اضافی. تنسورها رو میشه برای پردازش GPU (واحد پردازش گرافیکی) هم استفاده کرد که این باعث میشه محاسبات سریعتر انجام بشه.

- مشتق گیری خودکار با autograd

- این ویژگی برای ایجاد و آموزش شبکههای عصبی استفاده میشود. autograd به صورت خودکار مشتق عددی یک تابع رو با رویکرد پس انتشار خطا در شبکههای عصبی محاسبه میکند. این ویژگی طراحی و آموزش شبکههای عصبی را بسیار سادهتر میکند.

- یادگیری آسان

- پایتورچ ماهیت پایتونیک دارد و برای همین برای کدنویسهای پایتون، کار با این کتابخونه خیلی راحت هست.

- از طرفی داکیومنتهای خوب و سازماندهی شدهای برای یادگیری پایتورچ فراهم شده که به افراد کمک میکند کار با این فریمورک رو خیلی راحت یاد بگیرند.

- Debugging راحت

- پایتورچ استفاده از ابزار پایتون برای دیباگینگ پشتیبانی میکند و همین باعث میشه راحتتر بتونیم کدهارو دیباگ بکنیم.

- موازی سازی داده ها

- PyTorch می تواند به راحتی وظایف محاسباتی مختلف را بین GPU و CPUهای مختلف تقسیم کند. PyTorch دارای ویژگی موازیسازی داده است که می تواند به راحتی هر ماژول را در پردازش موازی قرار دهد.

معایب پایتورچ

- از آنجا که سال 2016 منتشر شده است، نسبت به سایر فریم ورکها، فعلا community کمتری دارد.

- مثل تنسور فلو، ابزار تصویرسازی و نظارتی ندارد.

- جامعه توسعهدهندگان این فریم ورک فعلا کوچک هست.

چارچوب کار با پایتورچ

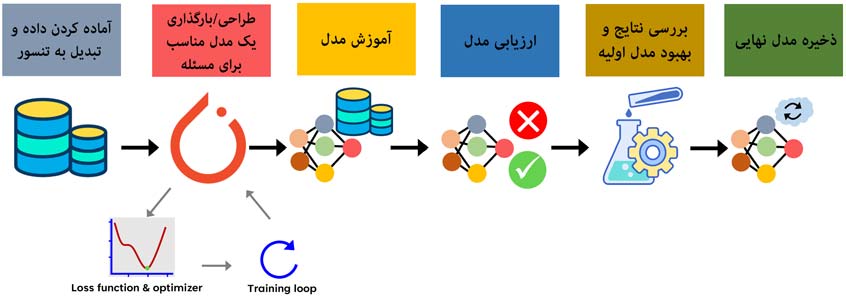

برای اینکه یک پروژه یادگیری ماشین در PyTorch انجام بدهیم باید طبق چنین چارچوبی کار رو پیش ببریم. در ابتدا داده را وارد محیط برنامه نویسی میکنیم. سپس به تنسور تبدیل میکنیم تا بتوانیم روی آن عملیات لازم رو انجام بدیم. در ادامه، یک مدل مناسب برای مسئله خود طراحی میکنیم. اینکه از چه شبکه عصبی استفاده کنیم و اون شبکه چه ساختاری داشته باشد، پارامترهای شبکه چی باشند، از چه تابع هزینه یا روش بهینه سازی برای یادگیری شبکه استفاده کنیم؟ همه اینا براساس دانشی که داریم انتخاب میکنیم. اینا هم که مشخص شد، میریم سراغ آموزش و تست مدل طراحی شده. اگه نتایج خوب باشه کار ما در طراحی تمام میشود و مدل نهایی رو ذخیره میکنیم که بتونیم بعدا ازش استفاده کنیم. اگه نتایج در حد انتظار نباشد، برمیگردیم مرحله دوم و ساختار و پارامترهای مدل اولیه رو تغییر میدهیم تا به یک سیستم بهینهتری برسیم.

ماژولهای مهم و کاربردی در PyTorch

ماژول autograd

مشتق گیری اساس یادگیری شبکه های عصبی مبتنی بر پس انتشار خطا است. ماژول autograd ماشین مشتق گیری خودکار پایتورچ است که کمک میکنه گرادیان در مسیر روبه جلو در زمان کوتاه محاسبه بشه. و این باعث میشه که ما درگیر مشتق گیری و کدنویسی های پیچیده نباشیم. Autograd یک نمودار غیر چرخه ای جهت دار ایجاد می کند که در آن برگها تانسور ورودی و ریشه ها تانسور خروجی هستند.

ماژولoptim

این ماژول یک پکیج با الگوریتمهای از پیش نوشته شده برای روشهای بهینه سازی است که برای آموزش شبکهها عصبی از آن استفاده میکنیم.

ماژول nn

این ماژول شامل کلاسهای مختلفی است که به ما کمک میکنه با آنها ساختار شبکه عصبی مورد نظرمون رو طراحی کنیم.

ماژول DataLoader

کار با دادههای بزرگ نیاز به بارگذاری یکباره کل داده در حافظه را دارد. این باعث قطع حافظه و اجرای بسیار کند برنامه ها می شود. علاوه بر این حفظ کد پردازش داده ها هم دشوار است. پایتورچ دو تا ماژول به اسم Datasets و DataLoader برای موازی سازی بارگذاری داده با رویکرد batching خودکار و برای خوانا و مدوله بودن کدها ارائه میدهد. Datasets و DataLoader به کاربران این امکان را می دهند که از داده های خود و همچنین مجموعه داده های از پیش بارگذاری شده استفاده کنند. در حالی که Dataset نمونهها و برچسبهای مربوطه را در خود جای میدهد، DataLoader مجموعه داده و نمونهگر را ترکیب میکند و یک تکرار در اطراف Dataset پیادهسازی میکند تا کاربران بتوانند به راحتی به نمونهها دسترسی داشته باشند. DataLoader یک کلاس داخلی است که روشی کارآمد و انعطاف پذیر برای بارگذاری داده ها در یک مدل برای آموزش ارائه می دهد. این ماژول به ویژه برای مدیریت مجموعه داده های بزرگی که نمی توانند در حافظه جا شوند و همچنین برای انجام پیش پردازش دادهها مفید است.

در پایتورچ باید چه چیزهایی یاد بگیریم؟

- کار با داده (datasets and dataloaders)

- کار با تنسورها

- طراحی مدل

- شبکههای عصبی

- تابع هزینه

- روش بهینهسازی

- آموزش مدل (بهینهسازی پارامترهای مدل)

- ذخیره و بارگذاری مدلها

در دوره تخصصی پایتورچ، همه مباحث مرتبط با پایتورچ رو یاد میگیریم. در این با دوره تئوری و ریاضیات شبکههای عصبی (توابع هزینه، روشهای بهینهسازی، توابع فعال، … ) آشنا میشیم و یاد میگیریم که چطور میشه شبکههای عصبی را با توابع هزینه و روش بهینهسازی مدنظر پیادهسازی کنیم و یا اینکه چطور از شبکههای عصبی در پروژههای عملی استفاده کنیم.

چه مهارت هایی در این دوره کسب میکنیم:

- یادگیری ریاضیات مرتبط با شبکه های عصبی

- آشنایی با انواع روشهای بهینهسازی در شبکههای عصبی

- پیادهسازی شبکههای عصبی

- استفاده از شبکههای عصبی در پروژههای تخصصی

- پیادهسازی مقالات مرتبط با شبکههای عصبی

- کار با کتابخانهPyTorch

- ساختdataloader

- طراحی شبکه عصبی با کمک ابزارPyTorch

- بدست دانش پایه لازم برای ورود تخصصی به حوزه دیپ لرنینگ

در فصل اول دوره پایتورچ رو معرفی میکنیم و با چارچوب کار در این محیط آشنا میشویم.

در فصل دوم دوره کار با تنسورها رو یاد میگیریم.

- ساخت تنسور

- آدرسدهی تنسور

- پیوند تنسورها

- عملیات ریاضیاتی/منطقی/مثلثاتی

- تبدیل آرایه به تنسور و برعکس

در فصل سوم دوره با datasetها و datalaoder آشنا میشویم.

- reading Datasets

- customised dataloaders

- data batching

- preprocessing

در فصل چهارم دوره با شبکه عصبی پرسپترون تک لایه آشنا میشویم.

- نورون

- پرسپترون تک لایه

- قانون پرسپترون

- رابطه وینرهاف

- گرادیان نزولی

- حداقل مربعات خطا

- ایراد شبکه عصبی تک لایه

در فصل پنجم شبکه عصبی پرسپترون چند لایه آشنا میشویم.

- پس انتشار خطا

- توابع هزینه (MSE, Cross Entropy)

- روشهای بهینهسازی (SGD, Momentum, AdaGrad, RMSprop, AdaDelta, Adam)

- توابع فعال و مشتقات آنها (Linear, Tanh, Sigmoid, ReLU, Softmax)

در فصل ششم هم شبکه های عصبی را با کمک پایتورچ پیاده سازی میکنیم.

- طراحی شبکه عصبی چندلایه

- بررسی تاثیر توابع فعال بر عملکرد و روند یادگیری شبکه

- بررسی تاثیر تعداد لایه ها بر عملکرد و روند یادگیری شبکه

- پیاده سازی شبکه عصبی کانولوشنال (CNN)

- نحوه ذخیره و بارگذاری شبکه های آموزش دیده در پایتورچ

این دوره بیسیک دیپ لرنینگ هست و برای هر فردی که میخواد به صورت تخصصی وارد حوزه دیپ لرنینگ شود خیلی میتونه مفید باشه

پیش نیاز کار با پایتورچ:

- آشنایی با اصول برنامهنویسی در پایتون (ضرروی است)

- آشنایی با کتابخانه NumPy (ضرروی است)

- آشنایی با کتابخانه matplotlib (خیلی ضروری نیست)

- آشنایی با برنامه نویسی شئیگرا (ضرروی است)

دیدگاه ها