شبکه عصبی

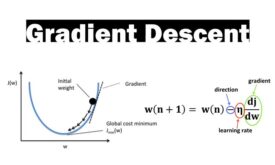

مطالعه مروری روشهای بهینهسازی مبتنی بر گرادیان نزولی

یادگیری در شبکههای عصبی به لطف مشتق و گرادیان نزولی(gradient descent) انجام میشه. در گرادیان نزولی، در هر تکرار آموزش شبکه عصبی شیب خطا محاسبه میشود و الگوریتم در جهت کاهش خطا حرکت میکند تا به حداقل خطای تصیمیم گیری…

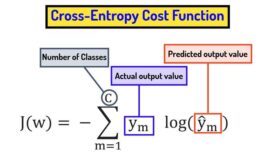

تابع هزینه cross entropy و تفاوت آن با مربعات خطا

تابع هزینه یک تابع ریاضیاتی است که عملکرد یک شبکه عصبی را در انجام یک تسک خاص اندازه گیری میکند. توابع هزینه نقش اساسی در یادگیری شبکه های عصبی دارند و به شبکه های عصبی کمک میکنند در راستای هدف…

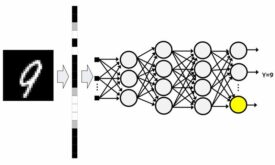

شبکه عصبی پرسپترون چند لایه و مسائل غیرخطی

شبکه عصبی پرسپترون چندلایه از سه نوع لایه ورودی، پنهان و خروجی تشکیل شده است. شبکه عصبی MLP از قانون یادگیری پس انتشار خطا برای تنظیم وزنهای سیناپسی خود استفاده میکند. از شبکه عصبی MLP میتوان در مسائل طبقه بندی،…

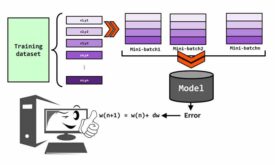

حالت های ارائه داده آموزشی به شبکه های عصبی (pattern, mini-batch, batch-mode)

در آموزش شبکه های عصبی، داده های آموزش را میتوان به سه شکل pattern mode, batch-mode و mini-batch به شبکه عصبی ارائه داد. هرکدام از این حالتها مزایا و معایب خودشون را دارند. در این پست میخواهیم با هر سه…

گرادیان نزولی و نقش آن در فرایند یادگیری شبکه های عصبی

گرادیان نزولی (gradient descent) یک الگوریتم بهینه سازی است که در شبکه های عصبی با کمک آن وزنهای سیناپسی تنظیم می شوند. به عبارتی با کمک گرادیان نزولی، شبکه های عصبی آموزش دیده و دانش لازم برای حل مئسله را…

شبکه عصبی و اهمیت مدل سازی مغز انسان

شبکه عصبی یک روشی در هوش مصنوعی است که به کامپیوتر یاد میدهد تا داده ها را به روشی پردازش کند که از مغز انسان الهام گرفته شده است. ولی سوال اساسی این است که چرا میخواهیم مغز انسان را…

کتابخانه پایتورچ (PyTorch)

پایتورچ یک فریم ورک یادگیری ماشین مبتنی بر کتابخانه Torch است. یک کتابخانه قدرتمند پایتون برای کاربردهایی مثل بینایی ماشین و پردازش زبان طبیعی است که اولین بار توسط تیم هوش مصنوعی متا (فیسبوک) توسعه پیدا کرد و در سال…

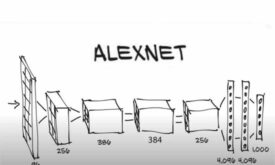

AlexNet:معماری که CNNها را به چالش کشید

سالها پیش، ما هنوز از دیتاستهای کوچکی مثل CIFAR, NORB استفاده میکردیم که متشکل از دهها هزار تصویر بودند. این دیتاستها برای مدلهای یادگیری ماشین مناسب بودند تا تسکهای تشخیص ساده را یاد بگیرند. با این حال، زندگی واقعی هرگز…

مفهوم کانولوشن در CNN

اگر بخواهیم تفاوت اصلی لایههای کانولوشن را با لایههای معمول شبکههای عصبی بیان کنیم، میتوانیم بگوییم لایههای Dense الگوهای global را در فضای ویژگی ورودی خود یاد میگیرند در حالیکه لایههای کانولوشن الگوهای local را یاد میگیرند. برای مثال یک…

تکنیکهای آموزش شبکه های عصبی بزرگ

ممکن است شبکههای عصبی عظیم، گزینهی مناسبی برای پروژهی شما باشند اما نگران روند آموزش آنها باشید. شبکههای عصبی بزرگ، مرکز اصلی پیشرفتهای اخیر در هوش مصنوعی هستند، اما آموزش این شبکهها چالش پژوهشی و مهندسی دشواری است که مستلزم…

5 روش برای جلوگیری از بیشبرازش شبکه عصبی

در پیاده سازی شبکه هایی عصبی، عمده ترین مشکلی که باهاش مواجه می شویم overfitting یا همان بیش برازش مدل هست. در این پست میخواهیم در مورد بیشبرازش و روشهایی جلوگیری از آن در شبکه عصبی صحبت کنیم.

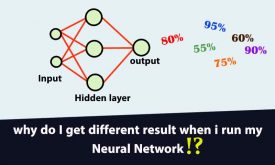

چرا هر موقع شبکه عصبی را اجرا میکنم جواب متفاوتی بدست می آید؟

روند یادگیری شبکه های عصبی مصنوعی به عوامل مختلفی وابسته است و عملکرد شبکه عصبی کاملا تحت تاثیر این عوامل قرار میگیرد. در پروژه ها اکثرا با این مشکل مواجه می شویم که شبکه عصبی در هر اجرا به یک…

- 1

- 2