معرفی مدل Segment Anything: اولین مدل پایه برای سگمنتبندی تصویر

- دسته:اخبار علمی

- هما کاشفی

سگمنت بندی (Segmentation) به معنی شناسایی پیکسلهای تصویر متعلق به یک شی است و یکی از تسکهای اصلی در بینایی ماشین است و در طیف گستردهای از برنامهها استفاده میشود از تحلیل تصاویر علمی گرفته تا ویرایش تصاویر. اما ایجاد یک مدل دقیق برای سگمنت بندی مناسب تسکهای خاص معمولاً مستلزم کار تخصصی کارشناسان فنی است که به زیرساختهای آموزشی هوش مصنوعی و حجم زیادی از دادهها دسترسی داشته باشند. مدل Segment Anything یا SAM یکی از جدیدترین مدلها برای سگمنت بندی تصاویر است که بسیاری از چالشهای مدلهای سگمنت بندی قبلی را حل کرده است.

کاهش نیاز به تخصص مدلسازی خاص تسک، محاسبات آموزشی و حاشیه نویسی دادههای سفارشی برای سگمنت بندی تصاویر، هستهی اصلی پروژهی Segment Anything است. برای تحقق این دیدگاه، هدف مدل SAM ایجاد یک مدل پایه برای تقسیم بندی تصویر بود: یک مدل سریع که روی دادههای متنوع آموزش دیده است و میتوان آن را برای تسکهای خاص به کار گرفت. با این حال، دادههای سگمنت بندی که برای آموزش چنین مدلی نیاز است به راحتی و آنلاین در دسترس نیست مانند دادههای تصویر، ویدیویی و متن که در اینترنت فراوان هستند. بنابراین خالقان Segment Anything تصمیم گرفتند به طور همزمان یک مدل سگمنت بندی عمومی ایجاد کنند و از آن استفاده کنند تا یک دیتاست سگمنت بندی در مقیاس بی سابقه ایجاد کنند.

SAM یک مفهوم کلی از چیستی اشیا را آموخته است و میتواند برای هر شی در تصویر یا ویدیو، ماسک تولید کند حتی اشیا و انواع تصاویری که در طول آموزش با آنها برخورد نکرده است. SAM یک مدل عمومی است و میتواند مجموعه وسیعی از کاربردها را پوشش دهد و ماسکها را برای انواع مختلف تصویر از عکسهای زیر آب یا میکروسکوپ سلولی تولید کند بدون اینکه به آموزش اضافی نیاز باشد (قابلیتی که اغلب به عنوان zero shot transfer شناخته میشود).

در آینده، SAM میتواند برای کمک به برنامههای کاربردی در حوزههای متعدی که نیاز به سگمنت بندی هر شی در تصویر دارند استفاده شود. برای جامعه تحقیقاتی هوش مصنوعی و دیگران، SAM میتواند یک جز از سیستمهای AI بزرگتر باشد که درک کلیتر و چند وجهی از جهان بدست آورند، به عنوان مثال درک محتوای بصری و متنی یک صفحه وب. مثلاً در حوزهی AR/VR، SAM میتواند یک شی را بر اساس نگاه کاربر شناسایی کند و سپس آن را نسخهی سه بعدی ارتقا دهد. برای سازندگان محتوا، SAM میتواند اپلیکیشنهای خلاقانه را بهبود دهد مانند استخراج نواحی تصاویر یا ویرایش ویدیو. SAM را میتوان برای کمک به مطالعات علمی رویدادهای طبیعی روی زمین یا حتی روی فضا به کار گرفت مانند موقعیت یابی حیوانات یا اشیا برای مطالعه و ردیابی در ویدیو. ما بر این باور هستیم که احتمالات گسترده هستند و در مورد کاربردهای بالقوهی مدل SAM که حتی تصورش را هم نکردهایم هیجان زده هستیم.

مدل عمومی Segment Anything را میتوان با سایر سیستمها ادغام کرد. SAM میتواند انواع ورودیها را بگیرد مانند دید کاربر از یک هدست AR/VR

SAM: رویکردی تعمیم یافته برای سگمنت بندی

پیش از این، برای حل هر نوع مسئلهی سگمنت بندی، دو دسته رویکرد وجود داشت. رویکرد اول interactive Segmentation امکان سگمنت بندی هر کلاسی از اشیا را فراهم میکرد اما به فردی نیاز بود تا با اصلاح مکرر ماسک، رویکرد را پیش ببرد. رویکرد دوم، automatic segmentation امکان سگمنت بندی دستههای خاص اشیا که از قبل تعریف شده بودند (مانند گربه، یا صندلی و…) را فراهم میکرد اما برای آموزش به میزان قابل توجهی دادهی حاشیه نویسی شده نیاز داشت (مثلاً هزاران یا حتی دهها هزار نمونه از تصاویر سگمنت بندی شدهی گربه) و همچنین به منابع محاسباتی و تخصص فنی برای آموزش مدل نیاز بود. هیچ یک از این دو رویکرد، یک رویکرد کلی و کاملاً خودکار برای سگمنت بندی ارائه نکردند.

مدل SAM تعمیم این دو دسته از رویکردهاست. این یک مدل واحد است که به راحتی میتواند سگمنت بندی تعاملی و سگمنت بندی خودکار را انجام دهد. واسط سریع مدل امکانی را فراهم میآورد تا در حوزههای انعطاف پذیری استفاده شود که طیف گستردهای از تسکهای سگمنت بندی را به سادگی با مهندسی کردن دستور مناسب برای مدل (کلیکها، کادرها، متن و غیره) ممکن میسازد. علاوه بر این SAM با مجموعه دادههای متنوع و با کیفیت بالا و با بیش از یک میلیارد ماسک آموزش دیده است (که به عنوان بخشی از این پروژه جمع آوری شدهاند) که این مدل را قادر میسازد تا به انواع جدیدی از اشیا و تصاویر فراتر از آنچه در طول آموزش مشاهده کرده است تعمیم یابد. این توانایی تعمیم به این معنی است که دیگر متخصصان نیازی به جمع آوری دادههای سگمنت بندی و تنظیم دقیق مدلی برای کاربردهای خود نخواهند داشت.

در مجموع، این قابلیتها SAM را قادر میسازد تا هم به تسکهای جدید و هم به دامنههای جدید تعمیم یابد. این انعطاف پذیری اولین مورد در نوع خود برای سگمنت بندی تصاویر است. در ادامه تصاویری ارائه شده است که برخی از قابلیتهای SAM را نشان میدهد:

(1)مدل SAM به کاربران این امکان را میدهد تا اشیا را فقط با یک کلیک روی نقاط به صورت تعاملی سگمنت بندی کنند تا شی را درج کنند یا آن را حذف کنند. این مدل همچنین میتواند یک bounding box ارائه دهد.

(2) مدل SAM میتواند در صورت مواجهه با ابهام در مورد شی که قرار است سگمنت بندی شود، ماسکهای معتبر متعددی را تولید کند که یک قابلیت مهم و ضروری برای حل مسائل سگمنت بندی در دنیای واقعی است.

(3)مدل SAM میتواند به طور خودکار همهی اشیا در یک تصویر را پیدا کرده و ماسک کند.

(4) مدل SAM میتواند برای هر درخواستی در زمان واقعی، ماسک ایجاد کند که امکان تعامل زمان واقعی را فراهم میکند.

نحوهی کار SAM: سگمنت بندی سریع

در پردازش زبان طبیعی و اخیراً بینایی ماشین، یکی از هیجان انگیزترین پیشرفتها، مدلهای پایهای است که میتواند یادگیری zero-shot و few-shot را برای دیتاستها و تسکهای جدید انجام دهد. خالقان SAM از این ایده، الهام گرفتند.

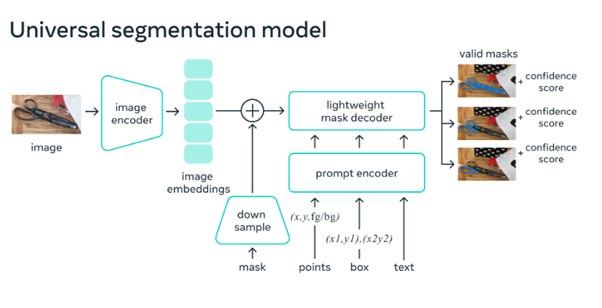

ما SAM را آموزش دادیم تا یک ماسک سگمنت بندی معتبر برای هر درخواستی را برگرداند که درخواست میتواند نقاط پس زمینه/پیش زمینه، یک کادر یا ماسک، متن آزاد باشد یا به طور کلی هر اطلاعاتی که نشان میدهد چه چیزی در یک تصویر سگمنت بندی شود. الزام یک ماسک معتبر به این معناست که حتی زمانی که یک درخواست مبهم است و ممکن است به چندین شی اشاره کند (برای مثال یک نقطه روی پیراهن ممکن است نشاندهندهی پیراهن یا شخص باشد) و خروجی باید یک ماسک معقول باشد.

همانطور که میدانیم تسکهای پیش آموزش و جمع آوری دادههای تعاملی، محدودیتهای خاصی بر طراحی مدل تحمیل میکند. به طور خاص، این مدل باید در زمان واقعی روی CPU روی یک مرورگر وب اجرا شود و به حاشیه نویسان این امکان را دهد تا از SAM به صورت تعاملی در زمان واقعی برای حاشیه نویسی کارآمد استفاده کنند. در حالیکه محدودیتهای زمان اجرا مستلزم مبادلهی بین کیفیت و زمان اجرالست، خالقان SAM متوجه شدند که یک طراحی ساده، نتایج خوبی را در عمل به همراه دارد.

پس از محاسبهی image embedding، SAM میتواند یک سگمنت را تنها در 50 میلی ثانیه با هر درخواستی در مرورگر وب تولید کند.

در مرورگر وب، SAM به طور موثر، ویژگیهای تصویر و یک مجموعه embedding را نگاشت میکند تا ماسک سگمنت بندی را تولید کند.

چه چیزی پیش رو است؟

در آینده، SAM را میتوان برای شناسایی هر آیتمی با عینکهای AR استفاده کرد و به کاربران، دستورالعملها و یادآوریها را ارائه دهد.

SAM این قابلیت را دارد تا روی طیف وسیعی از کاربردها اثر بگذارد-شاید روزی به مزرعه داران در کشاورزی کمک کند و یا به بیولوژیستها در پژوهشهایشان کمک کند.

سازندگان SAM گفتهاند:

«امیدواریم با به اشتراک گذاشتن پژوهشها و دیتاستهای خود بتوانیم پژوهشهای مربوط به سگمنت بندی تصویر و ویدیو را تسریع کنیم. مدل سگمنت بندی سریع ما میتواند تسک سگمنت بندی را به عنوان یک جز در سیستم بزرگتر انجام دهد. ترکیب، ابزار قدرتمندی است که به یک مدل این امکان را میدهد به گونهای توسعه پذیر استفاده شود و به طور بالقوه برای انجام تسکهای ناشناخته در زمان طراحی مدل به کار رود. ما پیش بینی میکنیم که طراحی سیستم ترکیب پذیر که با تکنیکهایی مانند مهندسی سریع فعال میشود، کاربردهای متنوعتری را نسبت به سیستمهایی که به طور خاص برای مجموعهای ثابت از تسکها آموزش دیدهاند را فعال میکند و SAM میتواند به یک جز قدرتمند در حوزههایی مانند AR/AV، ایجاد محتوا و سیستمهای عمومیتر AI تبدیل شود. هر چقدر پیش میرویم شاهد پیوند محکمتری بین درک تصاویر در سطح پیکسل و درک معنایی سطح بالاتر از محتوای بصری هستیم که راه را برای سیستمهای هوش مصنوعی قدرتمندتر باز میکند.

دیدگاه ها