اخبار علمی

یادگیری عمیق برای کاربردهای واسط مغز-کامپیوتر مبتنی بر EEG

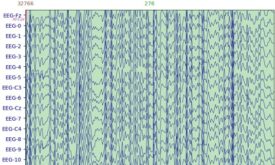

یادگیری عمیق، چشم اندازهای عالی برای حل تسکهای پیچیدهی مرتبط مانند کلاسبندی تصاویر حرکتی، تشخیص تشنج صرع و تشخیص توجه راننده با استفاده از دادهی EEG نشان داده است. محققان در حال حاضر کارهای زیادی روی رویکردهای مبتنی بر یادگیری…

معرفی دوره پردازش سیگنال قلبی-ECG

هر سیگنال حیاتی، روشهای پردازش خاص خودش را دارد، سیگنال ECG هم از از این قاعده مستثنی نیست و روشهای پردازش، مخصوصا پیش پردازش و استخراج ویژگی، مختص خودش را دارد. ما در دوره پردازش سیگنال قلبی (ECG) انواع روشهای…

الگوریتمهای یادگیری عمیق در پردازش سیگنال EEG

در سالهای اخیر، الگوریتمهای یادگیری عمیق به سرعت توسعه یافتهاند و در حال تبدیل شدن به ابزاری قدرتمند در مهندسی پزشکی هستند. به طور خاص، تمرکز زیادی بر کاربرد الگوریتمهای یادگیری عمیق در رمزگشایی وضعیت فیزیولوژیکی یا پاتولوژیک مغز از…

تنسورفلو یا پایتورچ، چرا PyTorch برای محققین انتخاب مناسبی است؟

تنسورفلو یا پایتورچ، مسئله این است! تنسورفلو (TensorFlow) و پایتورچ (PyTorch) دو پلتفرم قدرتمند یادگیری عمیق، به عبارت دو ستون اصلی در زمینه یادگیری عمیق هستند. تنسورفلو توسط گوگل توسعه پیدا کرده و به scalability و سازگاری مشهور است. در…

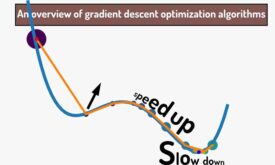

مطالعه مروری روشهای بهینهسازی مبتنی بر گرادیان نزولی

یادگیری در شبکههای عصبی به لطف مشتق و گرادیان نزولی(gradient descent) انجام میشه. در گرادیان نزولی، در هر تکرار آموزش شبکه عصبی شیب خطا محاسبه میشود و الگوریتم در جهت کاهش خطا حرکت میکند تا به حداقل خطای تصیمیم گیری…

تعریف ICA و نحوه ی اعمال آن در پکیج MNE-Python

روش تحلیل مولفههای مستقل (Independent Components Analysis (ICA)) تکنیکی برای برآورد سیگنالهای منابع مستقل از مجموعهای از ضبطهاست که در آن سیگنالهای منبع در نسبتهای ناشناخته با هم ترکیب شدهاند. در این مقاله با ICA آشنا می شویم و اینکه…

کتابخانههای ضروری مکمل کار با پکیج MNE پایتون

به منظور کار با پکیج MNE پایتون، شناخت و یادگیری چند مورد از کتابخانههای پایتون ضروری است. این کتابخانه در خواندن دیتاستهایی مثل EEG، ذخیره سازی و جداسازی و تقسیم دیتاست به بخشهای آموزش و آزمایش و همچنین استفاده از…

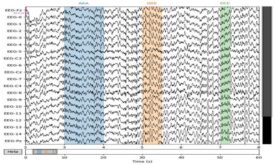

حاشیهنویسی سیگنال پیوسته با استفاده از پکیج MNE پایتون

با استفاده از پکیج MNE پایتون میتوانیم سیگنال پیوسته را نشانهگذاری یا به اصطلاح حاشیهنویسی کنیم و همچنین از این حاشیهنویسیها در مراحل بعدی پردازش استفاده کنیم. در این مقاله، روند انجام آن را توضیح میدهیم.

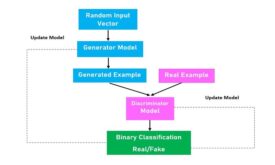

مقدمهای بر Generative Adversarial Networks (GANs) یا شبکههای مولد تخاصمی

شبکههای GAN حوزهای مهیج و به سرعت در حال تغییر هستند که نوید مدلهای مولد با قابلیت بالا را میدهند. برای مثال میتوانند نمونههای واقعی در طیف وسیعی از مسائل تولید کنند، مانند تبدیل تصاویر تابستان به زمستان، تبدیل تصاویر…

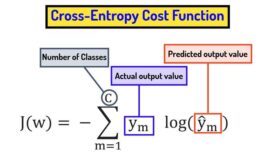

تابع هزینه cross entropy و تفاوت آن با مربعات خطا

تابع هزینه یک تابع ریاضیاتی است که عملکرد یک شبکه عصبی را در انجام یک تسک خاص اندازه گیری میکند. توابع هزینه نقش اساسی در یادگیری شبکه های عصبی دارند و به شبکه های عصبی کمک میکنند در راستای هدف…

خواندن و پردازش داده ی EEG فرمت .gdf با استفاده از پکیج MNE-Python

فرمت دادهی General Data Format (GDF) برای سیگنالهای پزشکی یک فرمت فایل دادهی پزشکی و علمی است. هدف GDF ترکیب و ادغام بهترین ویژگیهای همهی فرمتهای فایل بیوسیگنال در یک فرمت فایل واحد است. در این مقاله بررسی میکنیم که…

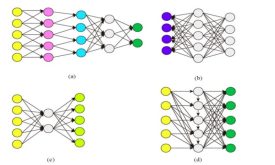

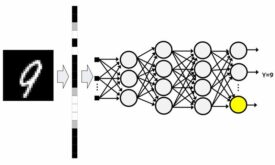

شبکه عصبی پرسپترون چند لایه و مسائل غیرخطی

شبکه عصبی پرسپترون چندلایه از سه نوع لایه ورودی، پنهان و خروجی تشکیل شده است. شبکه عصبی MLP از قانون یادگیری پس انتشار خطا برای تنظیم وزنهای سیناپسی خود استفاده میکند. از شبکه عصبی MLP میتوان در مسائل طبقه بندی،…