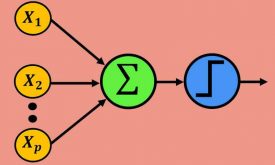

شبکه عصبی پرسپترون چند لایه با قانون یادگیری دلتا دلتا (delta delta rule)

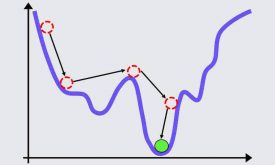

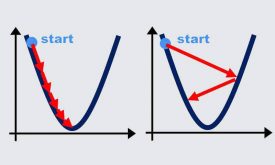

همانطور که در جلسه پنجم توضیح دادیم در پروژههای عملی تعیین نرخ یادگیری برای الگوریتم گرادیان نزولی بسیار سخت و چالش برانگیز است، زیرا که اگر نرخ یادگیری کم انتخاب شود، الگوریتم ممکن است در مینیممهای محلی گیر کند و در نتیجه شبکه به درستی آموزش نبیند و یا اگر نرخ یادگیری بزرگ انتخاب شود امکان دارد شبکه به حالت نوسانی و ناپایدار برسد و در نتیجه همگرا نشده و آموزش نبیند. برای حل این مشکل چند روش ساده از قبیل ترم ممنتوم، search then converge و time variant در متلب پیادهسازی کردیم و مزایا و معایب هر روش را توضیح دادیم و در انتها توضیح دادیم که روشهای ذکر شده با اینکه تا حدودی توانستهاند مشکل تعیین نرخ یادگیری را حل کنند ولی کافی نیستند و نیاز است که شرطهای دیگری نیز در تعیین نرخ یادگیری گنجانده شود.

در این جلسه شروط مورد نیاز جهت تعیین نرخ یادگیری بهینه را توضیح میدهیم و سپس تئوری الگوریتم یادگیری دلتا دلتا را توضیح داده و در نهایت در متلب به صورت گام به گام پیادهسازی میکنیم. و ایرادات اساسی این الگوریتم را توضیح میدهیم تا آماده شویم برای جلسه هفتم که الگورتیم دلتا بار دلتا را در آن آموزش میدهیم. الگورتیم دلتا بار دلتا گل سرسبد الگورتیمهای یادگیری پس انتشار خطا هست که به صورت بهینه نرخ یادگیری را تعیین میکند و مشکل اساسی الگوریتم پس انتشار خطا را حل میکند. برای اینکه جلسه هفتم را بهتر متوجه بشوید لازم است که این جلسه را مشاهده کنید.

پروژههای انجام شده در این جلسه

تشخیص سرطان سینه با شبکهی عصبی MLP با قانون یادگیری دلتا دلتا

ویدئوی زیر بخش کوتاهی از جلسهی ششم است که برای آشنایی در اختیار شما قرار داده شده است. بخش کامل این جلسه، و همچنین پکیج کامل شبکههای عصبی (شامل تمام جلسات) را از لینکهای زیر خریداری نمایید.

باتشکر

دیدگاه ها