شبکه عصبی

چگونه کشف اتفاقی Hubel و Wiesel پایهگذار بینایی ماشین و شبکههای عصبی کانولوشنی شد

در این پست داستان یکی از مهمترین کشفیات تاریخ علوم اعصاب و بینایی ماشین را بررسی میکنیم. David Hubel و Torsten Wiesel در دههٔ ۱۹۶۰ با یک آزمایش ساده و اتفاقی نشان دادند که نورونهای قشر بینایی چگونه به لبهها،…

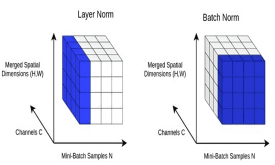

ساخت مدلهای یادگیری عمیق بهتر با Batch Normalization و Layer Normalization

دو رویکرد Batch Normalization و Layer Normalization دو استراتژی برای آموزش سریعتر شبکههای عصبی هستند بدون اینکه نیاز باشد برای مقدار دهی اولیهی وزنها و سایر تکنیکهای منظمسازی یا Regularization، احتیاط بیش از حد به خرج داد. در این آموزش،…

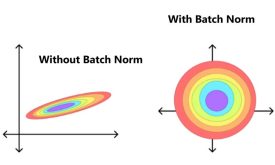

مفهوم Batch normalization در یادگیری عمیق

Batch Normalization یا نرمالسازی دستهای به عنوان یکی از تکنیکهای Generalization در یادگیری عمیق محسوب میشود که بطور مستقیم، در بهینهسازی مدلها نقش دارد. در واقع، پارامترهای ورودی را به کمک Adaptive normalization در مقیاسی مشابه قرار میدهد و اینگونه…

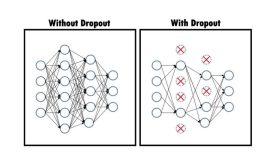

مفهوم Dropout در یادگیری عمیق

یکی از موانع بزرگ در الگوریتم های یادگیری عمیق، Overfitting است که برای مقابله با این پدیده، راهکارهای متعددی تاکنون توسط محققان ارائه شده است که در قالب تکنیکهای Generalization معرفی و در مقالات مورد استفاده قرار میگیرد. در این…

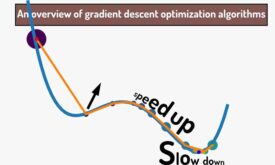

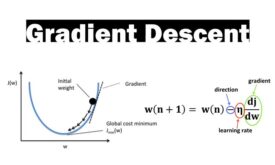

مطالعه مروری روشهای بهینهسازی مبتنی بر گرادیان نزولی

یادگیری در شبکههای عصبی به لطف مشتق و گرادیان نزولی(gradient descent) انجام میشه. در گرادیان نزولی، در هر تکرار آموزش شبکه عصبی شیب خطا محاسبه میشود و الگوریتم در جهت کاهش خطا حرکت میکند تا به حداقل خطای تصیمیم گیری…

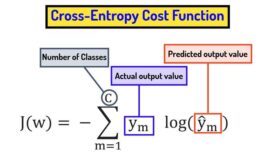

تابع هزینه cross entropy و تفاوت آن با مربعات خطا

تابع هزینه یک تابع ریاضیاتی است که عملکرد یک شبکه عصبی را در انجام یک تسک خاص اندازه گیری میکند. توابع هزینه نقش اساسی در یادگیری شبکه های عصبی دارند و به شبکه های عصبی کمک میکنند در راستای هدف…

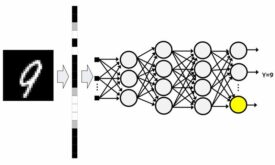

شبکه عصبی پرسپترون چند لایه و مسائل غیرخطی

شبکه عصبی پرسپترون چندلایه از سه نوع لایه ورودی، پنهان و خروجی تشکیل شده است. شبکه عصبی MLP از قانون یادگیری پس انتشار خطا برای تنظیم وزنهای سیناپسی خود استفاده میکند. از شبکه عصبی MLP میتوان در مسائل طبقه بندی،…

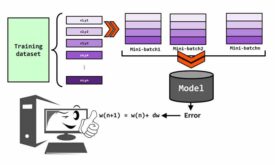

حالت های ارائه داده آموزشی به شبکه های عصبی (pattern, mini-batch, batch-mode)

در آموزش شبکه های عصبی، داده های آموزش را میتوان به سه شکل pattern mode, batch-mode و mini-batch به شبکه عصبی ارائه داد. هرکدام از این حالتها مزایا و معایب خودشون را دارند. در این پست میخواهیم با هر سه…

گرادیان نزولی و نقش آن در فرایند یادگیری شبکه های عصبی

گرادیان نزولی (gradient descent) یک الگوریتم بهینه سازی است که در شبکه های عصبی با کمک آن وزنهای سیناپسی تنظیم می شوند. به عبارتی با کمک گرادیان نزولی، شبکه های عصبی آموزش دیده و دانش لازم برای حل مئسله را…

شبکه عصبی و اهمیت مدل سازی مغز انسان

شبکه عصبی یک روشی در هوش مصنوعی است که به کامپیوتر یاد میدهد تا داده ها را به روشی پردازش کند که از مغز انسان الهام گرفته شده است. ولی سوال اساسی این است که چرا میخواهیم مغز انسان را…

کتابخانه پایتورچ (PyTorch)

پایتورچ یک فریم ورک یادگیری ماشین مبتنی بر کتابخانه Torch است. یک کتابخانه قدرتمند پایتون برای کاربردهایی مثل بینایی ماشین و پردازش زبان طبیعی است که اولین بار توسط تیم هوش مصنوعی متا (فیسبوک) توسعه پیدا کرد و در سال…

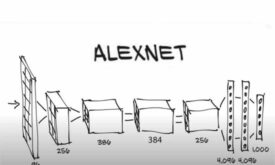

AlexNet:معماری که CNNها را به چالش کشید

سالها پیش، ما هنوز از دیتاستهای کوچکی مثل CIFAR, NORB استفاده میکردیم که متشکل از دهها هزار تصویر بودند. این دیتاستها برای مدلهای یادگیری ماشین مناسب بودند تا تسکهای تشخیص ساده را یاد بگیرند. با این حال، زندگی واقعی هرگز…