gradient descent

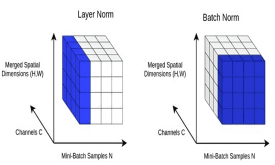

ساخت مدلهای یادگیری عمیق بهتر با Batch Normalization و Layer Normalization

دو رویکرد Batch Normalization و Layer Normalization دو استراتژی برای آموزش سریعتر شبکههای عصبی هستند بدون اینکه نیاز باشد برای مقدار دهی اولیهی وزنها و سایر تکنیکهای منظمسازی یا Regularization، احتیاط بیش از حد به خرج داد. در این آموزش،…

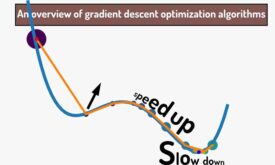

مطالعه مروری روشهای بهینهسازی مبتنی بر گرادیان نزولی

یادگیری در شبکههای عصبی به لطف مشتق و گرادیان نزولی(gradient descent) انجام میشه. در گرادیان نزولی، در هر تکرار آموزش شبکه عصبی شیب خطا محاسبه میشود و الگوریتم در جهت کاهش خطا حرکت میکند تا به حداقل خطای تصیمیم گیری…